AMCT基于TensorFlow框架运作,实现了神经网络模型中数据与权重低比特量化、稀疏、张量分解、模型部署优化(主要为算子融合)的功能,该工具优点如下:

- 使用方便,安装工具包即可。

- 接口简单,在用户基于TensorFlow框架的推理脚本基础上,调用API即可完成模型压缩。

- 与硬件配套,生成的压缩模型经过ATC工具转换后可在昇腾AI处理器上实现低比特推理。

- 量化、稀疏功能可配置,用户可自行修改量化和稀疏配置文件,调整压缩策略,获取较优的压缩结果。

- 压缩特性中的通道稀疏不依赖特定硬件支持,稀疏后的模型本身即存在存储和计算收益。

AMCT当前使用的压缩方法主要包括:量化、稀疏、组合压缩、近似校准和张量分解,量化过程中会实现模型部署优化(主要为算子融合)功能。

量化

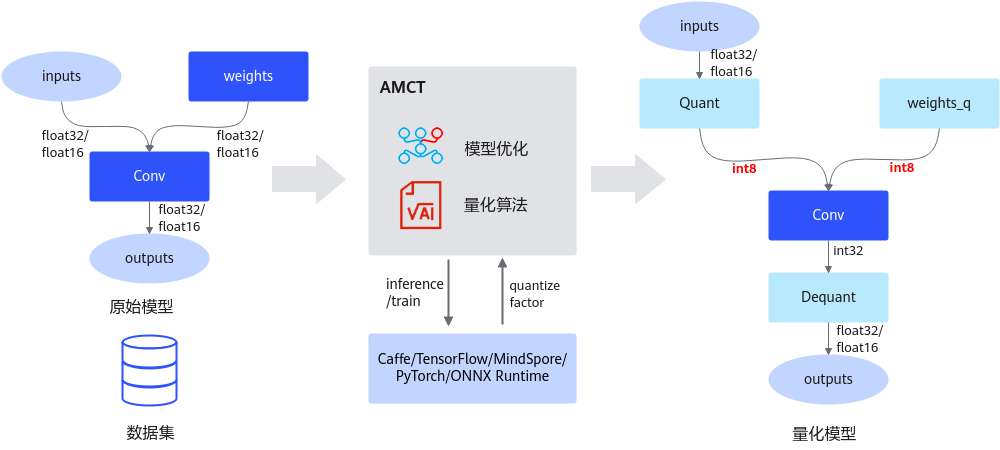

量化是指对模型的权重(weight)和数据(activation)进行低比特处理,让最终生成的网络模型更加轻量化,从而达到节省网络模型存储空间、降低传输时延、提高计算效率,达到性能提升与优化的目标。

AMCT将量化和模型转换分开,实现对模型中可量化层的独立量化,并将量化后的模型存为pb文件;其中量化后的仿真模型可以在CPU或者GPU上运行,完成精度仿真;量化后的部署模型可以部署在昇腾AI处理器上运行,达到提升推理性能的目的。经过AMCT量化后的TensorFlow模型,量化后的精度仿真模型和部署模型合二为一。

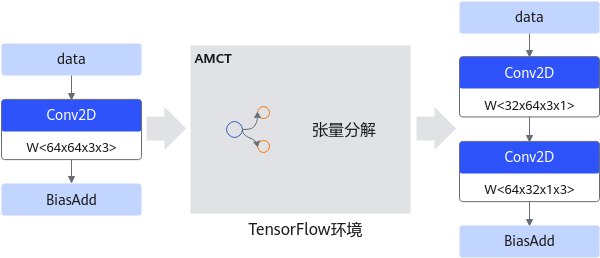

当前该工具仅支持对FP32/FP16数据类型的网络模型进行量化,以量化到INT8数据类型为例,其运行原理如下图所示。该特性详细介绍请参见量化。

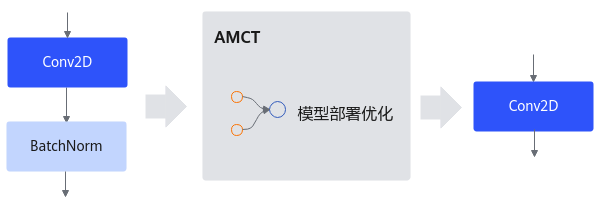

模型部署优化

主要为算子融合功能:是指通过数学等价,将模型中的多个算子运算融合单算子运算,以减少实际前向过程中的运算量,如将卷积层和BN层融合为一个卷积层。

其运行原理如下图所示。

稀疏

稀疏是通过结构剪枝的方式,对模型中的部分算子实现权重的稀疏化,从而得到一个参数量更小、计算量更小的网络模型。AMCT目前有两种稀疏方式:通道稀疏和4选2结构化稀疏。每次只能使能其中一种稀疏方式,即对于同一层可压缩算子,通道稀疏和4选2结构化稀疏不能同时配置。

通道稀疏与4选2结构化稀疏相比,稀疏颗粒度更大,对模型的精度影响也越大,但是能够获取到的性能收益也越大,用户可以根据实际情况选择一种稀疏方式。

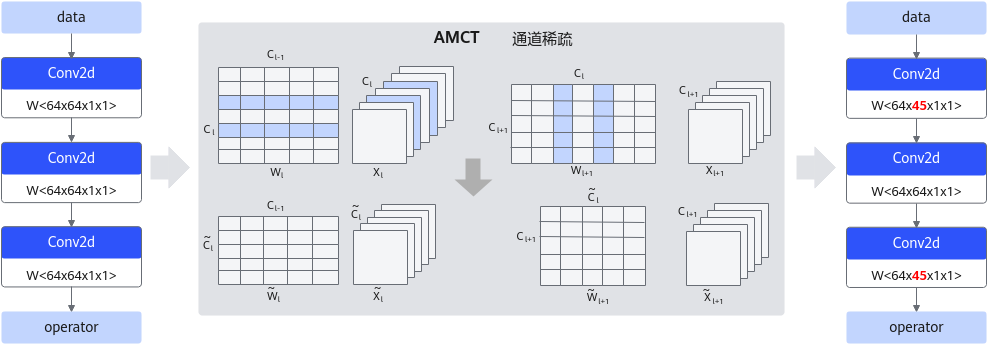

- 通道稀疏

通道稀疏基于重训练,通过裁剪网络通道数,在保持网络功能的前提下缩减模型参数量,从而降低整网的计算量。由于通道稀疏本身是依据通道的重要性进行裁剪,会裁剪掉重要性相对较低的通道,但是直接裁剪通道对网络精度影响较大,故裁剪后的模型需要进行重训练,以保证业务精度。通道稀疏的实现通常包括两个步骤:首先是通道选择,需要选择合适的通道组合以保留丰富的信息;然后是重建,需要使用选择的通道对下一层的输出进行重建。通道稀疏原理如下图所示。该特性详细介绍请参见通道稀疏。

图3 通道稀疏详细示意图

- 4选2结构化稀疏

由于硬件约束,Atlas 200/300/500 推理产品、Atlas 推理系列产品、Atlas 训练系列产品不支持4选2结构化稀疏特性:使能后获取不到性能收益。

4选2结构化稀疏基于重训练,在每4个连续的权重中保留2个重要性相对较高的权重,其余权重置0。因为稀疏的粒度较小,因此4选2结构化稀疏可以保留较多重要信息,具有细粒度稀疏的精度优势;同时4选2结构化稀疏在专门设计的硬件上可以降低运算量,具有结构化稀疏的性能优势。与通道稀疏不同的是,4选2稀疏并不改变权重的形状,因此不会影响上层或下层的算子。

原理如下图所示,在cin维度上相邻的4个元素为一组,在每组4个元素中保留绝对值最大的两个元素,如果cin不是4的倍数,填0补齐到4的倍数。该特性详细介绍请参见4选2结构化稀疏。

图4 4选2稀疏详细示意图

组合压缩

组合压缩是结合了稀疏和量化的特性,根据配置文件先进行稀疏,然后进行量化;在稀疏时根据相应算法插入稀疏算子,然后量化时,对稀疏后的模型插入数据和权重的量化层和SearchN的层,生成组合压缩模型,以期望得到更高的性能收益。生成组合压缩模型后,对模型进行重训练,保存为既可以进行精度仿真又可以部署的量化模型。

张量分解

深度学习运算,尤其是CV(计算机视觉)类任务运算,包含大量的卷积运算,而张量分解通过分解卷积核的张量,可以将一个大卷积核分解为两个小卷积核的连乘,即将卷积核分解为低秩的张量,从而降低存储空间和计算量,降低推理开销。

以1个64*64*3*3的卷积分解为32*64*3*1和64*32*1*3的级联卷积为例,可以减少1 - (32*64*3*1 + 64*32*1*3) / 64*64*3*3 = 66.7%的计算量,在计算结果近似的情况下带来更具性价比的性能收益。张量分解运行原理如下图所示。该特性详细介绍请参见张量分解。