MindIE是什么

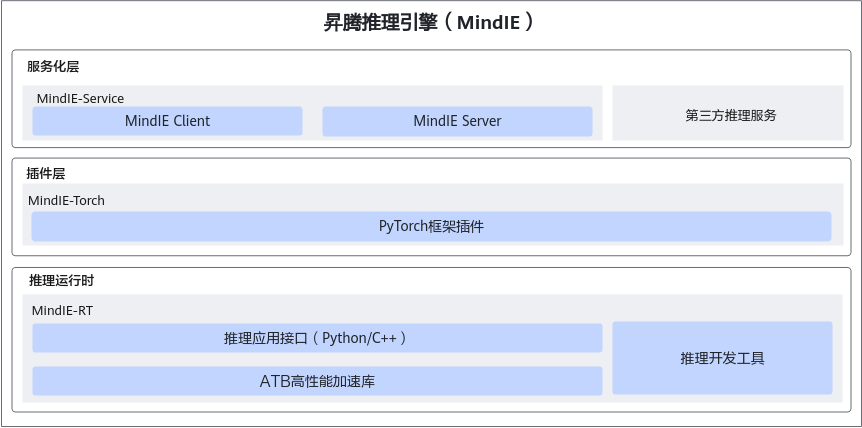

MindIE(Mind Inference Engine,昇腾推理引擎)是华为昇腾针对AI全场景业务的推理加速套件。通过分层开放AI能力,支撑用户多样化的AI业务需求,使能百模千态,释放昇腾硬件设备算力。向上支持多种主流AI框架,向下对接不同类型昇腾AI处理器,提供多层次编程接口,帮助用户快速构建基于昇腾平台的推理业务。

|

名称 |

说明 |

|---|---|

|

MindIE-Service |

MindIE-Service针对通用模型的推理服务化场景,实现开放、可扩展的推理服务化平台架构,支持对接业界主流推理框架接口,满足大语言模型的高性能推理需求。MindIE-Server作为推理服务端,提供模型服务化能力;MindIE-Client提供服务客户端标准API,简化用户服务调用。MindIE-Service向下调用了MindIE-RT组件能力。 |

|

MindIE-Torch |

MindIE-Torch是针对Pytorch框架模型的推理加速插件。Pytorch框架上训练的模型利用MindIE-Torch提供的简易C++/Python接口,少量代码即可完成模型迁移,实现高性能推理。MindIE-Torch向下调用了MindIE-RT组件能力。 |

|

MindIE-RT |

MindIE-RT是面向昇腾AI处理器的推理加速引擎,提供模型推理迁移相关开发接口及工具,能够将不同的深度学习框架(PyTorch、ONNX等)上完成训练的算法模型统一为计算图表示,具备多粒度模型优化、整图下发以及推理部署等功能。集成Transfomer高性能算子加速库ATB,提供基础高性能算子,和高效的算子组合技术(Graph)便于模型加速。 |

关键功能特性

- 服务化部署

提供用户侧接口、调度优化、多模型业务串流等能力。提供模型管理,DevOps等服务化调度能力,详情请参见《MindIE-Service开发指南》。

- 大模型推理

提供大模型推理能力,支持大模型业务全流程,逐级能力开放,使能大模型客户需求定制化,详情请参见《大模型推理迁移和优化指南》。

- Pytorch模型迁移

对接主流Pytorch框架,实现训练到推理的平滑迁移,提供通用的图优化并行推理能力,提供用户深度定制优化能力,详情请参见《MindIE-Torch开发指南》。

- 推理运行时

集成推理应用接口及Transformer加速库,提供推理迁移相关开发接口及工具,提供通用优化及并行推理能力,详情请参见《MindIE-RT开发指南》。