产品简介

随着人工智能产业的快速发展,业界越来越多的企业发布了深度学习平台,提供数据集管理、模型训练、模型管理、模型部署推理等功能满足模型开发训练推理的全流程业务,能够加速企业和开发者交付人工智能业务所需的模型。

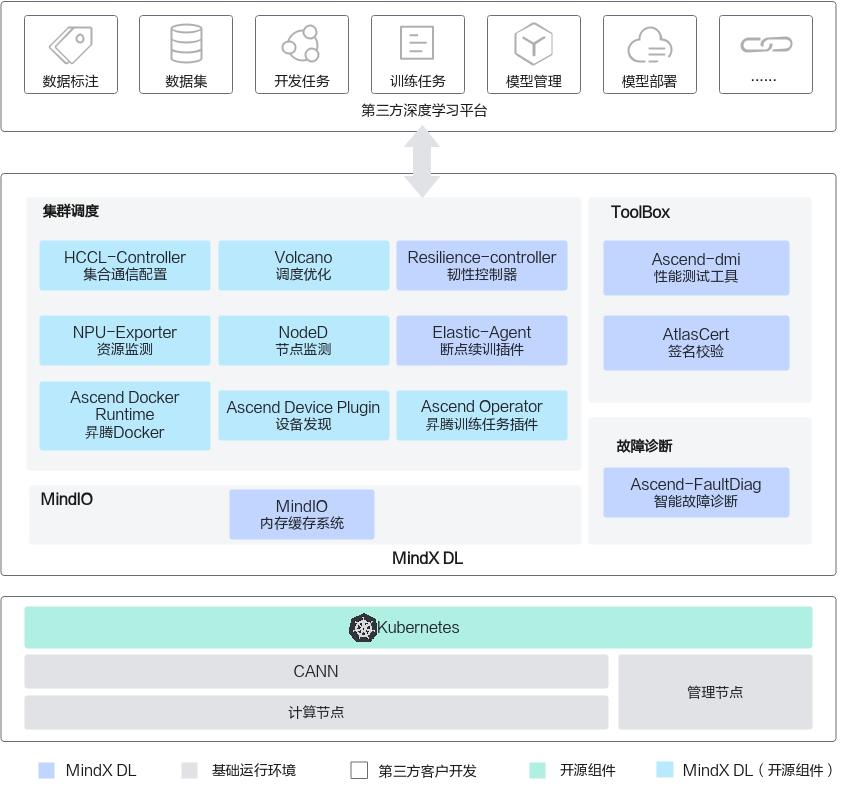

MindX DL(昇腾深度学习组件)是支持基于昇腾AI处理器(下文出现的NPU表示昇腾AI处理器)的数据中心训练和推理硬件的深度学习组件参考设计,提供昇腾AI处理器调度、集群性能测试等基础功能,为上层模型训练、模型评估、模型部署、模型推理等应用提供底层软件支持。深度学习平台开发厂商可以减少底层资源调度相关软件开发工作量,快速使能合作伙伴基于MindX DL开发深度学习平台。

MindX DL组件用于支持第三方深度学习平台完成训练推理流程,如图 产品定位所示。

- 集群调度:基于Kubernetes增强了对NPU的调度。并支持查看NPU、节点状态。

- ToolBox:为Atlas产品的标卡、板卡及模组类产品提供带宽测试、算力测试、功耗测试等功能。

- 故障诊断:提供日志清洗和故障诊断功能。

- MindIO:提供大模型训练中CheckPoint保存及加载的加速功能。

特性 |

组件 |

功能介绍 |

|---|---|---|

集群调度 |

Ascend Device Plugin |

基于Kubernetes设备插件机制,增加昇腾AI处理器的设备发现、设备分配、设备健康状态上报功能,使Kubernetes可以管理昇腾AI处理器资源。 |

HCCL-Controller |

华为研发的一款用于昇腾AI处理器训练任务的组件,利用Kubernetes(简称K8s)的informer机制,持续记录训练任务及其Pod的各种事件,并读取Pod的昇腾AI处理器信息,生成对应的configmap。该configmap包含了训练任务所依赖的集合通讯配置,方便训练任务更好地协同和调度底层的昇腾AI处理器,无需用户手动配置。 |

|

Volcano |

基于开源Volcano调度的插件机制,增加昇腾AI处理器的亲和性调度、故障重调度等特性,最大化发挥昇腾AI处理器计算性能。 |

|

NPU-Exporter |

该组件为Prometheus生态组件,提供了昇腾AI处理器资源各种指标的实时监测,可实时获取昇腾AI处理器利用率、温度、电压、内存,以及昇腾AI处理器在容器中的分配状况等信息。 |

|

NodeD |

提供节点状态上报功能,如节点心跳上报。 |

|

Elastic-Agent |

在数据并行、混合并行场景下提供策略恢复功能。 |

|

Resilience-Controller |

韧性控制器,提供弹性训练的韧性控制。在训练任务使用的硬件故障时,可以剔除该硬件,继续训练。 |

|

Ascend Docker Runtime |

容器引擎插件,为所有AI作业提供NPU容器化支持,使用户进行AI作业时能够以Docker容器的方式平滑地在昇腾设备上运行。 |

|

Ascend Operator |

支持MindSpore、PyTorch、TensorFlow三个AI框架在Kubernetes上进行分布式训练的插件,CRD(Custom Resource Definition)中定义了AscendJob任务,用户只需配置yaml文件,即可以为不同AI框架的分布式训练任务提供相应的环境变量。 |

|

ToolBox |

Ascend-dmi |

为Atlas产品的标卡、板卡及模组类产品提供带宽测试、算力测试、功耗测试等功能。 |

AtlasCert |

为软件包提供数据签名校验、CRL证书吊销列表的功能,保证软件包的安全性和CRL文件的有效性。 |

|

故障诊断 |

Ascend-FaultDiag |

日志清洗可从训练过程中产生的日志中提取关键信息,故障诊断可根据集群节点清洗后的文件中一键分析发生故障设备和根因。 |

MindIO |

MindIO |

MindIO加速大模型CheckPoint功能主要针对大模型训练中的CheckPoint的保存及加载进行加速,CheckPoint的数据先写入训练服务器的内存系统中,再异步写入后端的可靠性存储设备中。 |