开发应用时,如果涉及执行单个算子,请先参见AscendCL接口调用流程了解整体流程,再查看本节中的流程说明。

系统支持的算子请参见《算子清单》。

对于系统不支持的算子,用户需先参见《TBE&AI CPU算子开发指南》完成自定义算子开发。

单算子调用方式:单算子模型执行、单算子API执行

- 单算子API执行:基于C语言的API执行算子,无需提供IR(Intermediate Representation)定义,调用单算子API执行(试用特性)下的算子接口,例如Add算子,就调用aclnnAdd中的接口。

当前版本提供的NN类算子(aclnn)特性为试用特性,后续版本会存在变更,不支持应用于商用产品中。

- 单算子模型执行:基于图IR执行算子,先编译算子(例如,使用ATC工具将Ascend IR定义的单算子描述文件编译成算子om模型文件),再调用AscendCL接口加载算子模型(例如aclopSetModelDir接口),最后调用AscendCL接口执行算子(例如aclopExecuteV2接口)。

昇腾AI处理器对两种单算子调用方式的支持度如下表所示。

- |

单算子API执行 |

单算子模型执行 |

|---|---|---|

Atlas 200/300/500 推理产品 |

x |

√ |

Atlas 训练系列产品 |

√ |

√ |

Atlas A2训练系列产品 |

√ |

√ |

Atlas 推理系列产品 |

x |

√ |

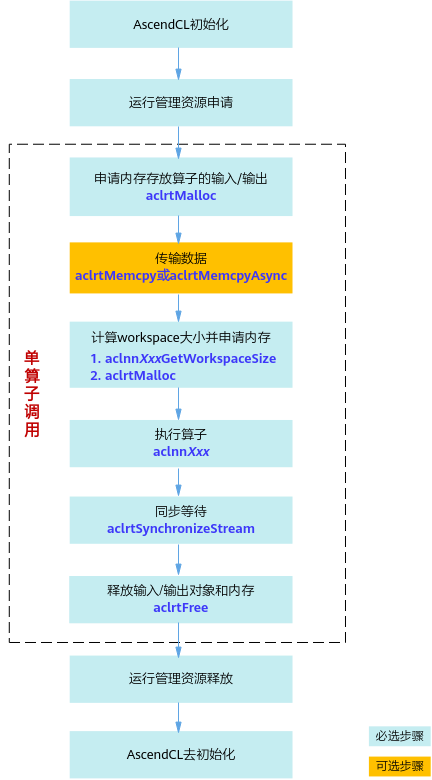

单算子API执行接口调用流程

以NN类算子API调用为例,具体调用流程如图1所示。

-

调用aclInit接口实现初始化AscendCL。

-

依次申请运行管理资源:Device、Context、Stream。具体流程,请参见运行管理资源申请与释放。

- 申请内存和传输数据。

- 调用aclrtMalloc接口申请Device上的内存,存放待执行算子的输入、输出数据。

- 调用aclCreateTensor、aclCreateIntArray等接口构造算子的输入、输出,如aclTensor、aclIntArray等,相关接口请参见“单算子API 执行 > 公共接口”。

如果需要将Host上数据传输到Device,则需要调用aclrtMemcpy接口(同步接口)或aclrtMemcpyAsync接口(异步接口)通过内存复制的方式实现数据传输。

- 计算workspace并执行算子。

- 调用aclnnXXXGetWorkspaceSize接口获取算子入参,并计算该算子执行流程需要多少的workspace内存。

- 调用aclrtMalloc接口,根据workspaceSize大小申请Device侧内存。

- 调用aclnnXXX接口执行计算并得到结果。

- 调用aclrtSynchronizeStream接口阻塞应用运行,直到指定Stream中的所有任务都完成。

如果需要将Device上算子执行结果数据传输到Host,则需要调用aclrtMemcpy接口(同步接口)或aclrtMemcpyAsync接口(异步接口)通过内存复制的方式实现数据传输。

- 运行管理资源释放。

- 调用aclDestroyTensor、aclDestroyIntArray等接口释放算子的输入、输出对象,相关接口请参见“单算子API 执行 > 公共接口”。

- 调用aclrtFree接口释放Device侧内存。

- 所有数据处理都结束后,需要依次释放运行管理资源:Stream、Context、Device。接口调用流程,请参见运行管理资源申请与释放。

- AscendCL去初始化。

调用aclFinalize接口实现AscendCL去初始化。

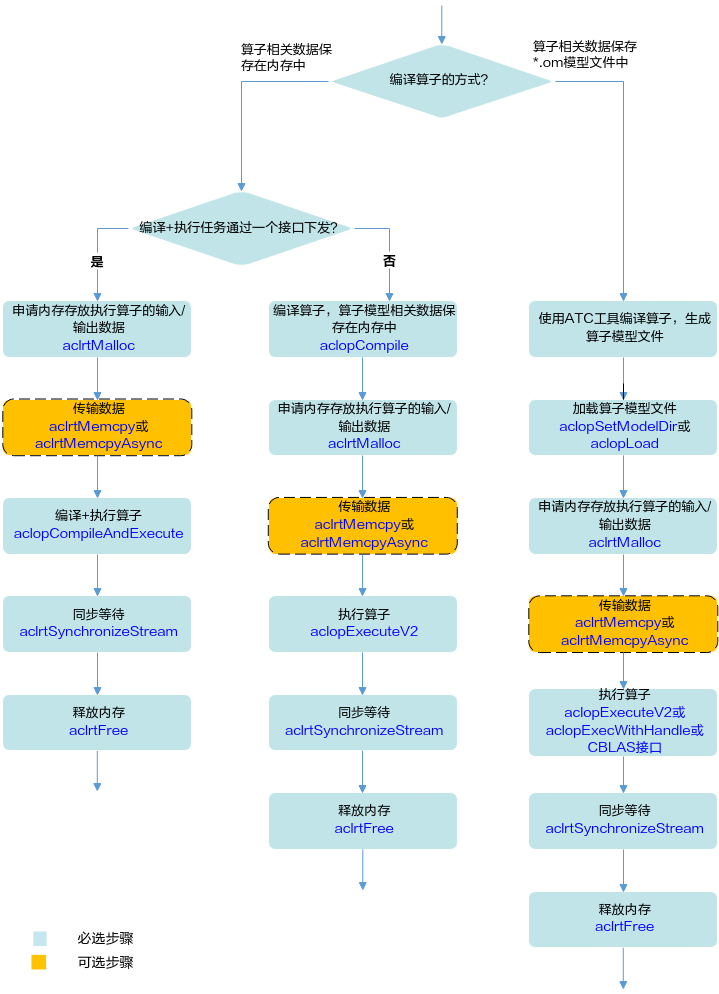

单算子模型执行接口调用流程

- 编译算子。

- 编译算子后,算子相关数据保存在*.om模型文件中

该种方式下编译算子,需使用ATC工具,详细描述请参见《ATC工具使用指南》,将单算子定义文件(*.json)编译成适配昇腾AI处理器的离线模型(*.om文件)。

- 编译算子后,算子相关数据保存在内存中

该种方式下编译算子,需调用AscendCL提供的接口,根据不同场景调用不同的接口:

- 对于同一个算子,编译一次,多次执行的场景,建议调用aclopCompile接口编译算子。编译算子后,依次进行3、4、5、6、7。

- 对于编译算子、执行算子次数相同的场景,建议先执行3,再调用aclopCompileAndExecute接口编译算子。编译算子后,再依次进行6、7。

- 编译算子后,算子相关数据保存在*.om模型文件中

- 加载算子模型文件。

支持以下2种方式中的一种加载单算子模型文件:

- 调用aclopSetModelDir接口,设置加载模型文件的目录,目录下存放单算子模型文件(*.om文件)。

- 调用aclopLoad接口,从内存中加载单算子模型数据,由用户管理内存。单算子模型数据是指“单算子编译成*.om文件后,再将om文件读取到内存中”的数据。

- 调用aclrtMalloc接口申请Device上的内存,存放执行算子的输入、输出数据。

如果需要将Host上数据传输到Device,则需要调用aclrtMemcpy接口(同步接口)或aclrtMemcpyAsync接口(异步接口)通过内存复制的方式实现数据传输。

- 动态Shape场景,如果无法明确算子的输出Shape时,在执行算子前,还需推导或预估算子的输出Shape。

需用户调用aclopInferShape接口、aclGetTensorDescNumDims接口、aclGetTensorDescDimV2接口、aclGetTensorDescDimRange等接口,推导或预估算子的输出Shape,作为算子执行接口aclopExecuteV2的输入。

- 执行算子。

- 对于被封装成AscendCL接口的算子(参见CBLAS接口),包括GEMM算子、Cast算子,目前支持以下两种执行方式:

- 不以handle方式执行算子,接口名称中不包含“Handle”关键字,例如,调用aclblasGemmEx接口(封装GEMM算子)、aclopCast接口(封装Cast算子)等执行算子。

- 以handle方式执行算子,接口名称中包含“Handle”关键字,例如,调用aclblasCreateHandleForGemmEx接口、aclopCreateHandleForCast接口等创建handle后,还需要调用aclopExecWithHandle接口执行算子。

- 对于未被封装成AscendCL接口的算子,目前支持以下两种执行方式:

- 不以handle方式执行算子,调用aclopExecuteV2接口执行算子。

- 以handle方式执行算子,调用aclopCreateHandle接口创建handle,再调用aclopExecWithHandle接口执行算子。

不以handle方式执行算子时,每次执行算子时,系统内部都会根据算子描述信息匹配内存中的模型。

以handle方式执行算子时,系统内部将算子描述信息匹配到内存中的模型,并缓存在Handle中,每次执行算子时,无需重复匹配算子与模型,因此在涉及多次执行同一个算子时,效率更高,但该方式不支持动态Shape算子,且Handle使用结束后,需调用aclopDestroyHandle接口释放。

- 对于被封装成AscendCL接口的算子(参见CBLAS接口),包括GEMM算子、Cast算子,目前支持以下两种执行方式:

- 调用aclrtSynchronizeStream接口阻塞应用运行,直到指定Stream中的所有任务都完成。

- 调用aclrtFree接口释放内存。

如果需要将Device上的算子执行结果数据传输到Host,则需要调用aclrtMemcpy接口(同步接口)或aclrtMemcpyAsync接口(异步接口)通过内存复制的方式实现数据传输,然后再释放内存。