CANN算子类型介绍

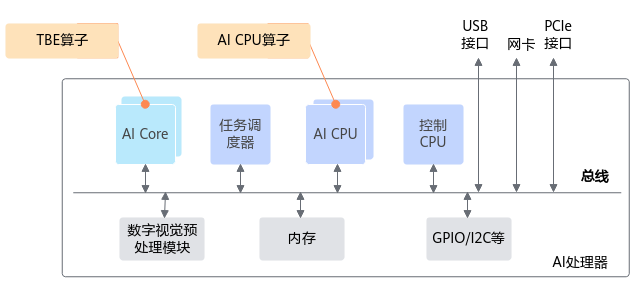

首先看下CANN算子在昇腾AI处理器中的位置,如图1所示,其中:

- AI Core是昇腾AI处理器的计算核心,负责执行矩阵、向量、标量计算密集的算子任务,在AI Core上执行的算子称为TBE(Tensor Boost Engine)算子。

- AI CPU负责执行不适合跑在AI Core上的算子,是AI Core算子的补充,主要承担非矩阵类、逻辑比较复杂的分支密集型计算,在AI CPU上执行的算子称为AI CPU算子。

由上面可以看出,CANN算子有两种类型,TBE算子与AI CPU算子。

若存在相同算子类型的TBE算子与AI CPU算子,TBE算子的执行优先级高于AI CPU算子。

父主题: 背景知识