接口简介

概述

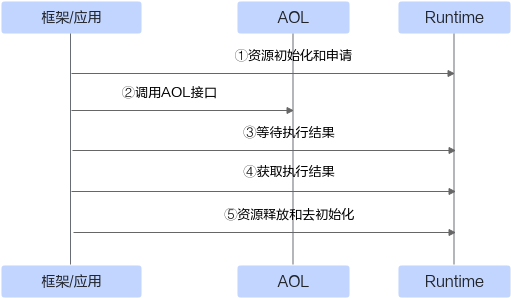

为加速模型算力释放,CANN(Compute Architecture for Neural Networks)提供了算子加速库(Ascend Operator Library,简称AOL)。该库提供了一系列丰富且深度优化过的高性能算子API,更亲和昇腾AI处理器,调用流程如图1所示。开发者可直接调用算子库API使能模型创新与应用,以进一步提升开发效率和获取极致模型性能。

接口说明

本文档针对不同领域的算子API阐述了具体的接口定义、功能描述、参数说明、约束限制和调用示例等,指导开发者快速上手调用算子API。此外,还提供不同框架IR(Intermediate Representation)定义的算子规格信息,方便开发者自行构建网络模型。

- 各类算子接口或算子规格/清单支持的产品型号具体参见表2。

- 对于各类算子接口或算子规格/清单中未审明支持的场景(如产品型号、数据类型、数据格式、数据维度等),不推荐开发者使用,当前版本不保证其调用效果。

- 调用算子接口过程中可能会遇到各类异常,可以参考《故障处理》中“故障案例集 > 算子执行问题”,该章提供了典型/高频的算子执行问题,辅助开发者进行问题定位和解决。