如何确定原始框架网络模型中的算子与昇腾AI处理器支持的算子的对应关系

问题现象

用户使用精度比对工具或者性能比对工具进行算子精度或者性能分析时,若发现某些算子精度或者性能有问题,可能会考虑使用ATC工具中的某些参数调整算子的计算精度后,重新进行模型转换然后推理,比如通过--modify_mixlist参数将有问题的算子配置为黑名单等,该场景下,ATC中的参数要求配置的必须为基于Ascend IR定义的算子的OpType。

那如何获取此类算子的OpType?或者如何通过原始框架网络模型中的算子,来获取我们昇腾AI处理器对应支持的算子的OpType呢?

解决办法

- 如果用户正在使用Profiling工具进行算子性能分析,该场景下直接获取昇腾AI处理器支持的算子类型即可,参见《性能分析工具使用指南》手册:

- 导出summary数据中的“AI Core和AI CPU算子数据”,文件名为“op_summary_*.csv”格式。

- 该文件中的“OP Type”列即为昇腾AI处理器支持的算子的OpType,从该列中找到有问题的算子即可。

- 如果用户正在使用精度比对工具进行算子精度分析:

- 参见《精度比对工具使用指南》手册获取精度比对结果文件result_*.csv。

- 根据该文件中的“NPUDump”列找到有问题的算子名,然后到对应dump数据文件中检索对应的OpType。

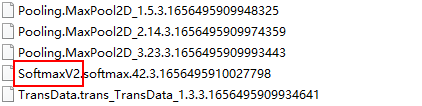

dump数据的第一段即为昇腾AI处理器支持的算子的OpType,例如下图dump数据中标红部分的算子信息:

父主题: FAQ