自定义算子入图

当开发者在执行PyTorch/TensorFlow网络或者基于算子原型构造Ascend Graph时,如果遇到了“算子加速库”中不支持的算子,需要开发者先开发自定义算子,再将自定义算子入图。

本章节给出这几种场景下自定义算子开发及入图的整体流程。

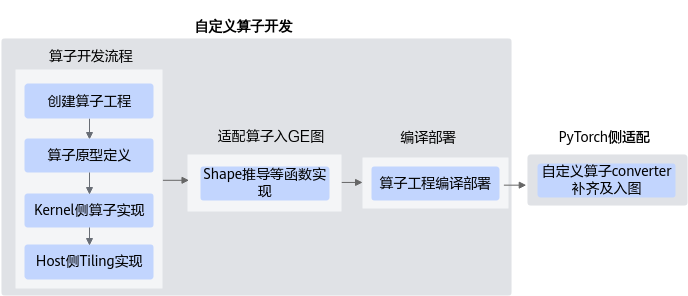

PyTorch网络自定义算子开发

自定义Ascend C算子并将其入PyTorch图执行的开发流程如下图所示:

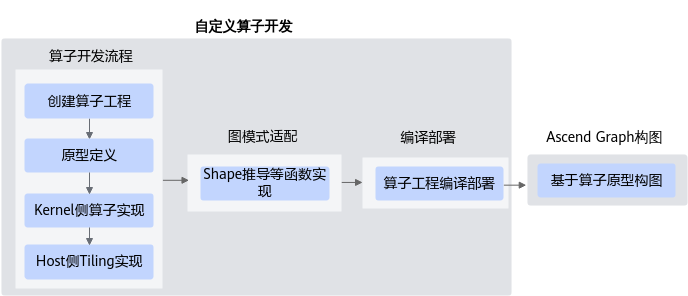

Ascend Graph构图

自定义Ascend C算子并将其入Ascend Graph执行的开发流程如下图所示:

- 自定义算子开发。

- Ascend Graph构图。

基于自定义算子构造Ascend Graph图的方式与其他CANN内置算子相同,通过算子原型调用即可,典型流程可参见Ascend Graph构图。