分布式训练简介

本节描述分布式训练的基本概念以及典型组网。

什么是分布式训练

在深度学习中,当数据集和参数量的规模越来越大,训练所需的时间和硬件资源会随之增加,最后会变成制约训练的瓶颈。分布式并行训练,可以降低对内存、计算性能等硬件的需求,是进行训练的重要优化手段。

分布式训练通过将计算任务按照一定的方法拆分到不同的昇腾AI处理器上来加速模型的训练速度,拆分的计算任务之间通过集合通信来完成信息的汇总和交换,完成整个训练任务的并行处理,从而实现加快计算任务的目的。

根据并行的原理及模式不同,业界主流的并行类型有以下几种:

- 数据并行(Data Parallel):对数据进行切分的并行模式,一般按照batch维度切分,将数据分配到各个计算单元(worker)中,进行模型计算。数据并行方法将数据分配到不同的节点之上,而模型则被复制到每一个节点,每次迭代中,每个昇腾AI处理器用自己的那一份数据进行计算。在数据并行中,模型参数的同步是非常重要的一步,目前支持Allreduce架构和ParameterServer架构两种同步模式。

- 模型并行(Model Parallel):对模型进行切分的并行模式。包括层内模型并行模式,即对参数切分后分配到各个计算单元中进行训练。

- 混合并行(Hybrid Parallel):指数据并行、模型并行等多种方式混合使用。

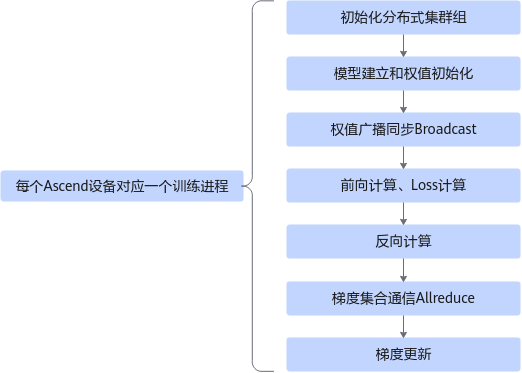

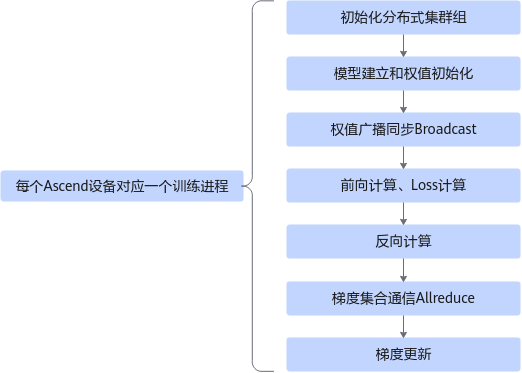

图1 分布式场景下的训练业务执行流程

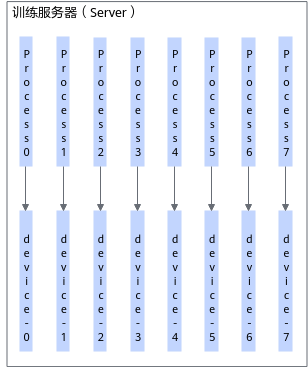

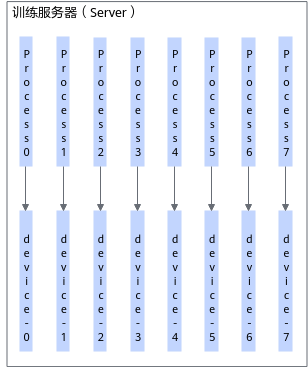

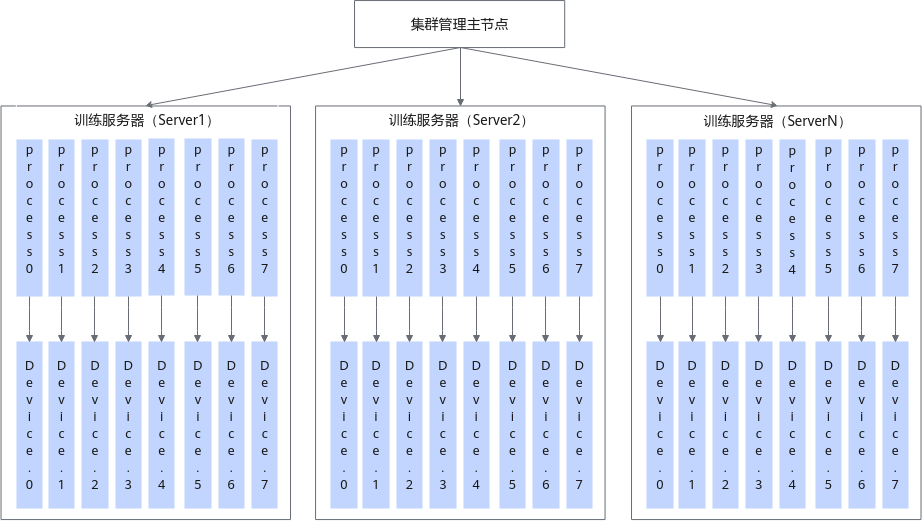

Server单机

Server单机场景,即由1台训练服务器(Server)完成训练。

图2 典型单机训练组网

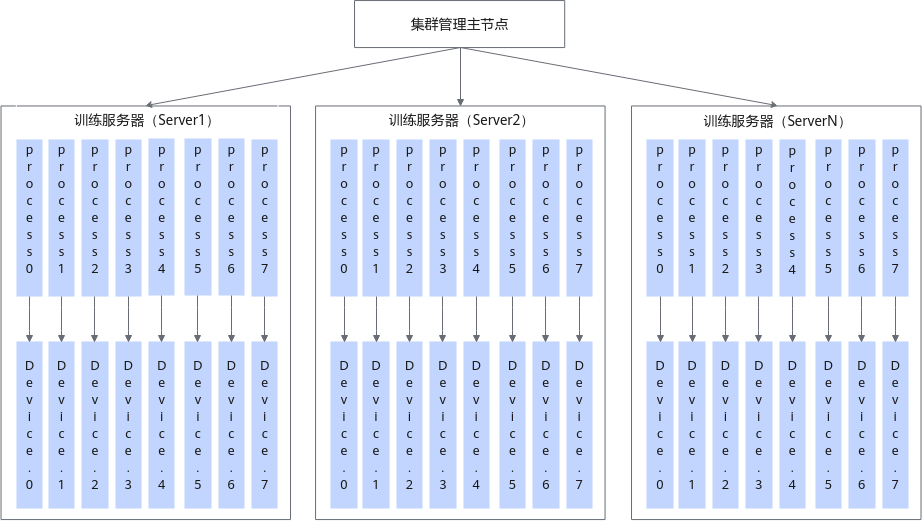

Server集群

Server集群场景,即由集群管理主节点+一组训练服务器(Server)组成训练服务器集群。

图3 典型集群训练组网

集群管理主节点支持集群及集群内设备的管理能力,同时支持整个集群内的分布式作业管理。

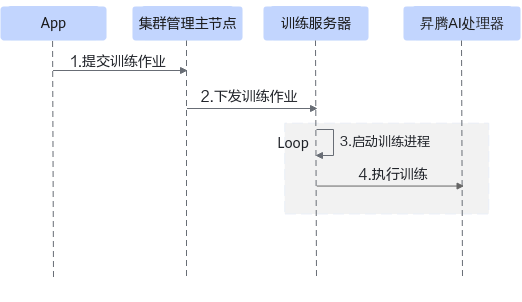

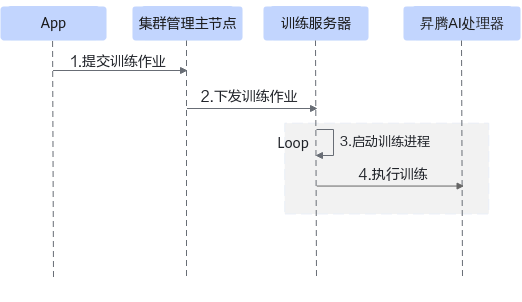

集群训练场景下,一个分布式训练执行流程如下:

图4 分布式训练执行流程

训练作业经过集群管理主节点下发到训练服务器,由服务器上的作业Agent根据App指定的设备数量,启动相应个数的TensorFlow进程执行训练,一个TensorFlow进程和一个昇腾AI处理器对应。

父主题: 入门学习