接口简介

概述

为加速模型算力释放,CANN(Compute Architecture for Neural Networks)提供了算子加速库(Ascend Operator Library,简称AOL)。

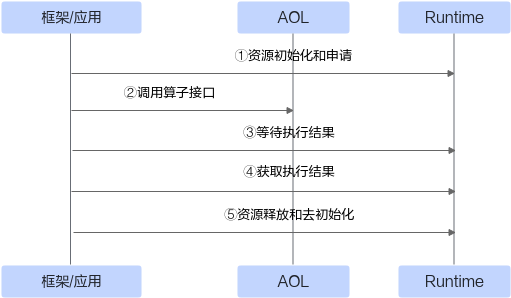

该库提供了一系列丰富的深度优化、硬件亲和的高性能算子,如Neural Network、Digital Vision Pre-Processing算子等,为神经网络在昇腾硬件上加速计算奠定了基础。为方便开发者调用算子,提供了单算子API执行方式调用算子(基于C语言的API,无需提供IR(Intermediate Representation)定义),以便开发者高效使能模型创新与应用,API的调用流程如图1所示。

此外,本文档还提供了不同深度学习框架IR(Intermediate Representation)定义的算子规格信息,支撑开发者自行构建网络模型。

接口说明

本文档提供的不同领域算子接口或算子规格清单如表1所示,其在不同产品型号的支持情况参见表2。

算子接口章节重点阐述了接口定义、功能描述、参数说明、约束限制和调用示例等,指导开发者快速上手调用算子API。