如何确定原始框架网络模型中的算子与昇腾AI处理器支持的算子的对应关系

问题描述

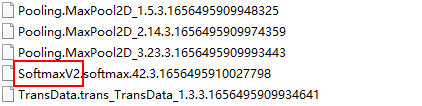

用户使用精度比对工具或者性能比对工具进行算子精度或者性能分析时,若发现某些算子精度或者性能有问题,可能会考虑使用ATC工具中的某些参数调整算子的计算精度后,重新进行模型转换然后推理,比如通过--modify_mixlist参数将有问题的算子配置为黑名单等,该场景下,ATC中的参数要求配置的必须为基于Ascend IR定义的算子的OpType。

那如何获取此类算子的OpType?或者如何通过原始框架网络模型中的算子,来获取我们昇腾AI处理器对应支持的算子的OpType呢?

父主题: 常见问题处理