简介

概述

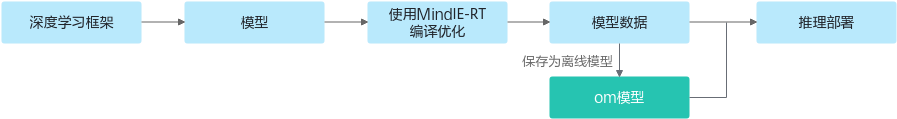

MindIE-RT(Mind Inference Engine RT,昇腾推理引擎运行时)是针对昇腾AI处理器的推理加速引擎,提供AI模型推理场景下的商业化部署能力,能够将不同的深度学习框架(PyTorch、等)上完成训练的算法模型统一为计算图表示,具备多粒度模型优化、整图下发以及推理部署等功能。采用MindIE-RT推理引擎所完成模型推理加速流程如图1所示。MindIE-RT集成昇腾高性能算子加速库ATB,为实现基于Transformer的神经网络推理加速引擎库,库中包含了各类Transformer类模型的高度优化模块,如Encoder和Decoder部分。

MindIE-RT专注于为用户提供快速迁移、稳定精度以及极致性能的推理服务,让用户能够脱离底层硬件细节和不同平台框架的差异,专注于推理业务本身,实现高效的模型部署开发。并且专门针对大模型下的Transformer架构,提高Transformer模型性能,提供了基础的高性能的算子,高效的算子组合技术(Graph),方便模型加速。目前MindIE-RT已实现动态输入推理,解析框架模型等功能特性,详情请见功能特性。

功能特性

MindIE-RT支持以下功能特性:

- 支持多语言API(C++, Python):详情参见C++编程模型和Python编程模型。

- 提供parser,支持直接导入人工智能框架ONNX模型,详情参见解析框架模型。

- 支持Transformer算子加速库,集成基础高性能算子,详情可见ATB高性能加速库使用。

- 支持丰富的编译时优化方法和运行时优化方法,用户可以在昇腾AI处理器上占用较少的内存,部署更高性能的推理业务,提供的优化方法如:精度优化和常量折叠。

应用场景

MindIE-RT是基于昇腾AI处理器的部署推理引擎,适用于通过NPU、GPU、CPU等设备训练的算法模型,为其提供极简易用且灵活的接口,实现算法从训练到推理的快速迁移。

目前MindIE-RT的快速迁移能力已支持(但不限于)以下业务场景:

- 计算机视觉。

- 自然语言处理。

- 推荐、检索。

- 大模型对话。