拉取镜像方式

本章节指导用户进行MindIE容器镜像部署,请确保服务器能够连接网络。

获取MindIE容器镜像

- 单击MindIE容器镜像链接,进入到社区版资源下载页面。

- 单击ATB Models后方的“下载”按钮,弹出MindIE镜像获取页面。

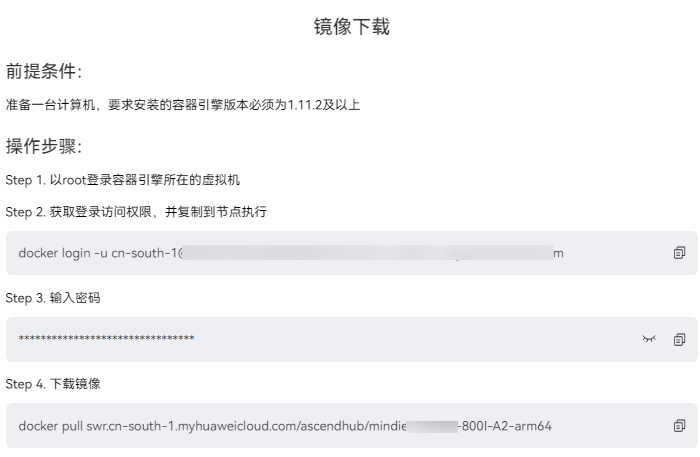

- 在MindIE镜像页面的“镜像版本”页签申请权限(使用华为账号登录,如果没有请先注册),填入如下所示信息,单击“提交申请”按钮。图1 镜像申请页面

- 待申请审批后,根据用户环境单击对应镜像后方的“立即下载”按钮。

- 根据弹出的下载页面提示,下载镜像,操作指导如图2所示。

使用镜像

- 执行以下命令启动容器。

docker run -it -d --net=host --shm-size=1g \ --name <container-name> \ # 请设置容器名称 --device=/dev/davinci_manager \ --device=/dev/hisi_hdc \ --device=/dev/devmm_svm \ --device=/dev/davinci0 \ # 对应具体的卡号,可以仅设置需要的设备 --device=/dev/davinci1 \ --device=/dev/davinci2 \ --device=/dev/davinci3 \ --device=/dev/davinci4 \ --device=/dev/davinci5 \ --device=/dev/davinci6 \ --device=/dev/davinci7 \ -v /usr/local/Ascend/driver:/usr/local/Ascend/driver:ro \ -v /usr/local/sbin:/usr/local/sbin:ro \ -v /path-to-weights:/path-to-weights:ro \ # 请修改权重挂载目录/path-to-weights mindie:1.0.RC3-800I-A2-arm64 bash # 请修改为实际的镜像名称

容器启动命令仅供参考,可根据需求自行修改。

- 执行以下命令进入容器。

docker exec -it <container-name> bash

- 使用模型进行推理。

以LLama 3系列模型为例,具体可参考容器中“$ATB_SPEED_HOME_PATH/examples/models/llama3/README.md”中的说明。

执行以下命令进行推理:

cd $ATB_SPEED_HOME_PATH python examples/run_pa.py --model_path /path-to-weights # 请修改权重路径

显示默认问题“Question”和推理结果“Answer”,如下所示:

2024-11-18 11:08:13,291 [INFO] [pid: 389497] logging.py-180: Question[0]: What's deep learning? 2024-11-18 11:08:13,291 [INFO] [pid: 389497] logging.py-180: Answer[0]: Deep learning is a subset of machine learning that uses neural networks to learn from data. Neural networks are 2024-11-18 11:08:13,291 [INFO] [pid: 389497] logging.py-180: Generate[0] token num: (0, 20)

若用户想要自定义输入问题,可使用“--input_texts”参数设置,如:

python examples/run_pa.py --model_path /path-to-weights --input_texts "What is deep learning?" # 请修改权重路径

“$ATB_SPEED_HOME_PATH”已在“.bashrc”中已设置好,无需自行设置。

- 启动服务。

MindIE Service是面向通用模型场景的推理服务化框架,通过开放、可扩展的推理服务化平台架构提供推理服务化能力,支持对接业界主流推理框架接口,满足大语言模型的高性能推理需求。请参考《MindIE Service开发指南》。

以下为简易的启动方法:

1. 修改“$MIES_INSTALL_PATH/conf/config.json”,具体参数含义与配置规则请参考《MindIE Service开发指南》的“MindIE Service组件 > MindIE Server > 配置参数说明”章节。

2. 使用后台进程方式启动服务:

cd $MIES_INSTALL_PATH nohup ./bin/mindieservice_daemon > output.log 2>&1 &

3. 在标准输出流捕获到的文件中,打印如下信息说明启动成功:

Daemon start success!

“$MIES_INSTALL_PATH”已在“.bashrc”中已设置好,无需自行设置。

父主题: 容器化部署和镜像制作