使用样例

限制与约束

- 仅

Atlas 800I A2 推理产品 支持此特性。 - LLaMa3.1-70b浮点模型 和Qwen2-72B 浮点模型支持对接此特性。

- 暂不支持与LoRA特性配合。

- 该特性不能和PD分离特性同时使用。

操作步骤

本章节简单介绍如何使用Splitfuse功能。

- 配置MindIE Server的config.json配置文件,参数解释请参见配置说明。

cd ${mindie-service安装路径} vi conf/config.jsonSplitFuse特性必须额外配置的参数如下:

- 在ModelDeployConfig中的“ModelConfig”下添加:

"plugin_params": "{\"plugin_type\":\"splitfuse\"}"

- 在ScheduleConfig中修改“templateType”参数为Mix:

"templateType": "Mix",

- 在ScheduleConfig中设置“policyType”参数,详细策略请参见配置说明。

"policyType": 0,

- 在ScheduleConfig中添加SplitFuse相关的关键参数:

"enableSplit": true, "splitType": false, "splitStartType": false, "splitChunkTokens": 512, "splitStartBatchSize": 16

保存修改后的配置并启动服务化:

./bin/mindieservice_daemon

- 在ModelDeployConfig中的“ModelConfig”下添加:

- 使用以下样例启动Benchmark。

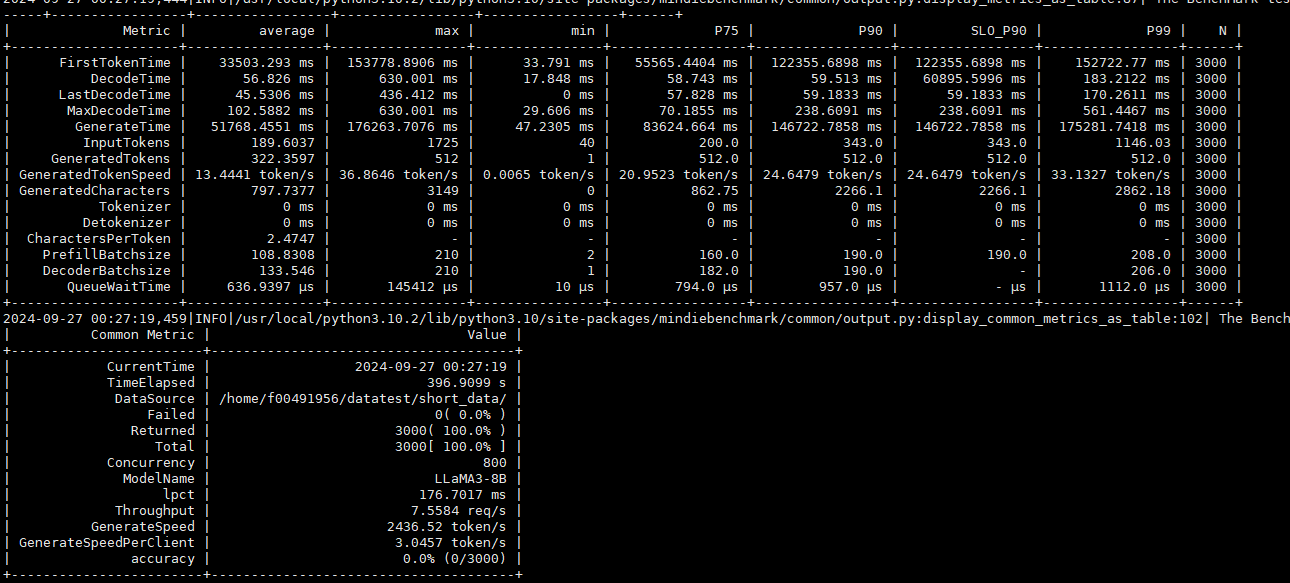

benchmark \ --DatasetPath "/{数据集路径}/GSM8K" \ --DatasetType "gsm8k" \ --ModelName "baichuan2_13b" \ --ModelPath "/{模型路径}/baichuan2-13b" \ --TestType client \ --Http https://{ipAddress}:{port} \ --ManagementHttp https://{managementIpAddress}:{managementPort} \ --MaxOutputLen 512Benchmark输出结果如下所示:

父主题: Splitfuse