模型推理测试

- 若为Atlas 800I A2 推理服务器请执行以下步骤。

进入容器后,执行以下命令,运行ChatGLM3-6B推理样例。“/home/weight/chatglm3-6b”为容器的模型权重路径。

cd /usr/local/Ascend/llm_model bash examples/models/chatglm/v2_6b/run_800i_a2_pa.sh /home/weight/chatglm3-6b

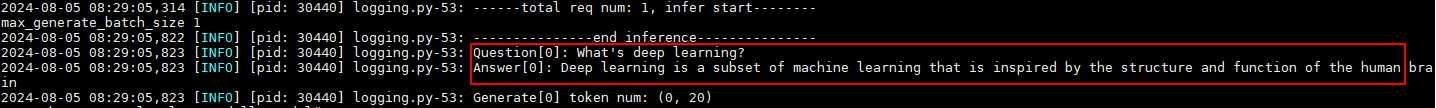

回显如图1所示信息,表示推理成功。

- 若为Atlas 800 推理服务器(型号:3000)配置Atlas 300I Duo 推理卡请执行以下步骤。

进入容器后,执行以下命令,运行ChatGLM3-6B推理样例。“/home/weight/chatglm3-6b”为容器的模型权重路径。

cd /usr/local/Ascend/llm_model bash examples/models/chatglm/v2_6b/run_300i_duo_pa.sh /home/weight/chatglm3-6b

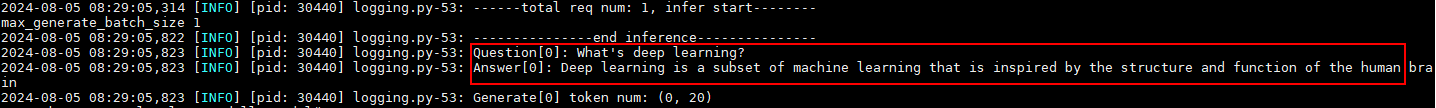

回显如图2所示信息,表示推理成功。

父主题: 模型开箱