算子部署(本地)

- 在MindStudio工程界面菜单栏依次选择。弹出算子部署界面。

- 在弹出的界面中选择“Operator Deploy Locally”,在“Operator Package”中选择指定的算子库OPP包目录并单击“Operator deploy”。

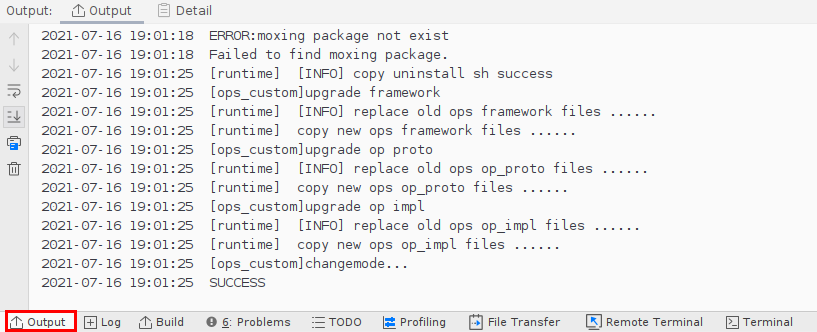

在下方Output页签出现如下信息,代表自定义算子部署成功。

自定义算子包安装成功后,会将自定义算子部署在Ascend-cann-toolkit安装目录/ascend-toolkit/latest/opp目录下或指定的算子库OPP目录下的对应文件夹中。

目录结构示例如下所示:

├── opp //算子库目录 │ ├── op_impl │ ├── built-in │ ├── custom │ ├── ai_core │ ├── tbe │ ├── config │ ├── soc_version //昇腾AI处理器BS9SX1A AI处理器版本 │ ├── aic-soc_version-ops-info.json //自定义算子信息库文件 │ ├── custom_impl //自定义算子实现代码文件 │ ├── add.py │ ├── vector_core //此目录预留,无需关注 │ ├── framework │ ├── built-in │ ├── custom │ ├── caffe │ ├── tensorflow //存放tensorflow框架的自定义算子插件库 │ ├── libcust_tf_parsers.so │ ├── npu_supported_ops.json //Ascend 910场景下使用的文件,Ascend 310场景下无需关注 │ ├── op_proto │ ├── built-in │ ├── custom │ ├── libcust_op_proto.so //自定义算子原型库文件

父主题: TBE算子开发