简介

AI技术已经开始成为各行各业提升生产效率的热门技术,其中AI模型是企业的核心资产,为了防止攻击者非法滥用和窃取模型,保护关键资产的安全性,对模型的保护越来越迫切。本文档介绍了边缘推理场景下的模型的保护方案以及第三方平台对接配置指导,介绍在推理场景下使用模型保护功能的配置方法。

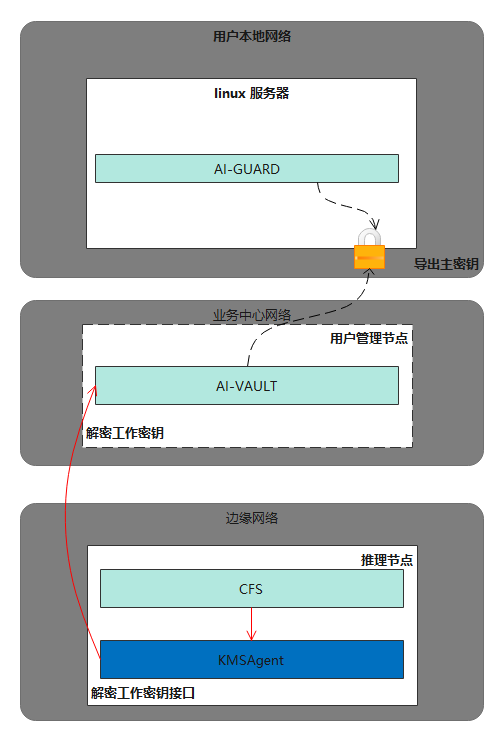

模型保护整体方案如图1所示,由AI-VAULT组件提供中心密钥控制服务,负责主密钥和预共享密钥的控制,加/解密工作密钥的部署,完成一系列密钥准备工作,用户使用AI-GUARD组件工具加密模型文件并上传至边缘设备,在边缘设备容器中部署Crypto_fs组件(简称CFS),该组件提供透明解密的能力,Crypto_fs通过KMSAgent向AI-VAULT请求解密工作密钥,在容器中解密模型文件并执行推理任务,各组件说明参考准备组件。

模型保护应用于边缘推理场景,在数据(模型和推理程序)的传输和存储过程中,对用户的模型和推理程序进行加密保护,目的是防止外部攻击者通过攻破边缘设备窃取模型资产。以下场景的攻击不能被阻止,请在部署运行的过程中关注处理:

- 推理设备侧高权限用户(推理设备管理员、拥有相关capability、sudo等权限的用户)通过内存直接窃取模型或窃取到加密PSK口令和KMSAgent私钥。

- AI-VAULT侧的高权限用户(管理节点设备管理员、拥有相关capability、sudo等权限的用户)拿到密钥,或者破坏操作系统程序和文件。

- 用户加密目录外的推理程序依赖的其他程序和应用被篡改,来自Device侧的攻击等。