安装说明

本文主要向用户介绍基于AI集群-Atlas 900 A2 PoDc 集群基础单元,如何快速完成昇腾NPU(Neural-Network Processing Unit,神经网络处理器单元)驱动固件、CANN(Compute Architecture for Neural Networks,AI异构计算架构)软件的安装,各软件说明如表1所示。

软件类型 |

软件介绍 |

|---|---|

昇腾NPU固件 |

固件包含昇腾AI处理器自带的OS 、电源器件和功耗管理器件控制软件,分别用于后续加载到AI处理器的模型计算、芯片启动控制和功耗控制。 |

昇腾NPU驱动 |

部署在昇腾服务器,用于管理查询昇腾AI处理器,同时为上层CANN软件提供芯片控制、资源分配等接口。 |

CANN |

部署在昇腾服务器,包含Runtime、算子库、图引擎、媒体数据处理等组件,通过AscendCL(Ascend Computing Language,昇腾计算语言)对外提供Device管理、Context管理、Stream管理、内存管理、模型加载与执行、算子加载与执行、媒体数据处理等API,帮助开发者实现在昇腾软硬件平台上开发和运行AI业务。

CANN软件按照功能主要分为Toolkit(开发套件)、Kernels(二进制算子包)、NNAE(深度学习引擎)、NNRT(离线推理引擎)、TFPlugin(TensorFlow框架插件)几种软件包,各软件包支持功能范围如下:

|

Ascend Docker |

Ascend Docker(容器引擎插件)本质上是基于OCI标准(开放容器倡议标准)实现的Docker Runtime(容器运行环境),不修改Docker引擎,对Docker以插件方式提供Ascend NPU适配功能,使用户AI作业能够以Docker容器的方式平滑运行在昇腾设备上。 |

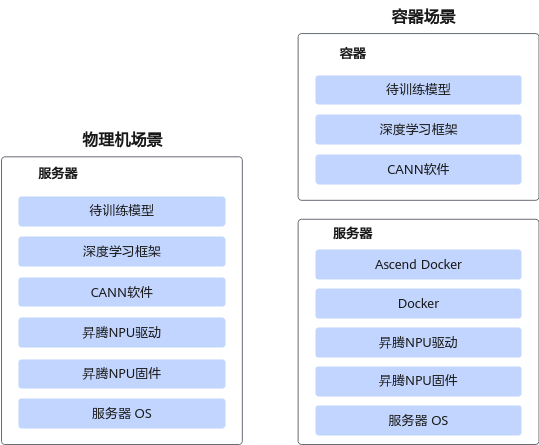

安装场景

本文以物理机和容器场景介绍Toolkit和Kernels的安装方法。

物理机和容器部署架构如图1所示。CANN软件以Toolkit和Kernels为例,容器场景需要部署Ascend Docker(容器引擎插件)。

方案中Docker为业界通用的容器软件,华为没有进行定制。