算法介绍

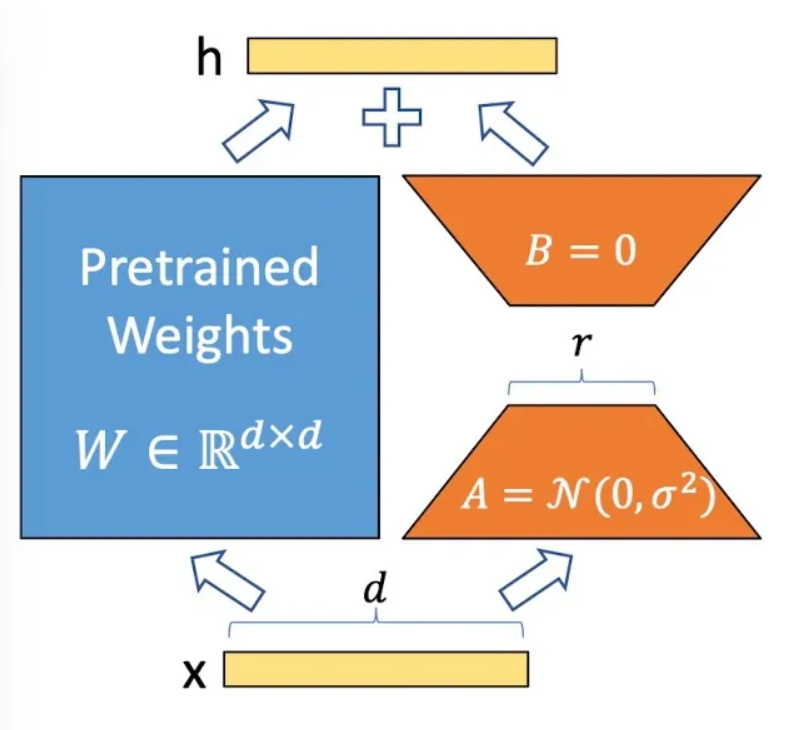

LoRA算法是一种针对超大语言模型的轻量化微调算法,通过使用两个低维度的矩阵乘积近似原始模型中线性结构的权重矩阵,在下游任务微调时,冻结原始网络参数,仅更新LoRA矩阵,来减少微调参数数量。实验结果表明,添加了LoRA结构的Transformer模型,在仅更新少数参数的情况下,微调后精度近似全参微调。

算法原理如图1所示,算法具体细节可参考相关论文LoRA: Low-Rank Adaptation of Large Language Models。

LoRA算法原理图:在原Dense层增加一个旁支,包含两个低维度的矩阵A与矩阵B,训练时只需更新这两个矩阵的参数。

父主题: LoRA算法