算法介绍

Low-Rank Adapter算法是Adapter算法的一种演进,沿用了Adapter的放置位置和训练方式,只是重新设计了更加轻量化的Adapter结构。

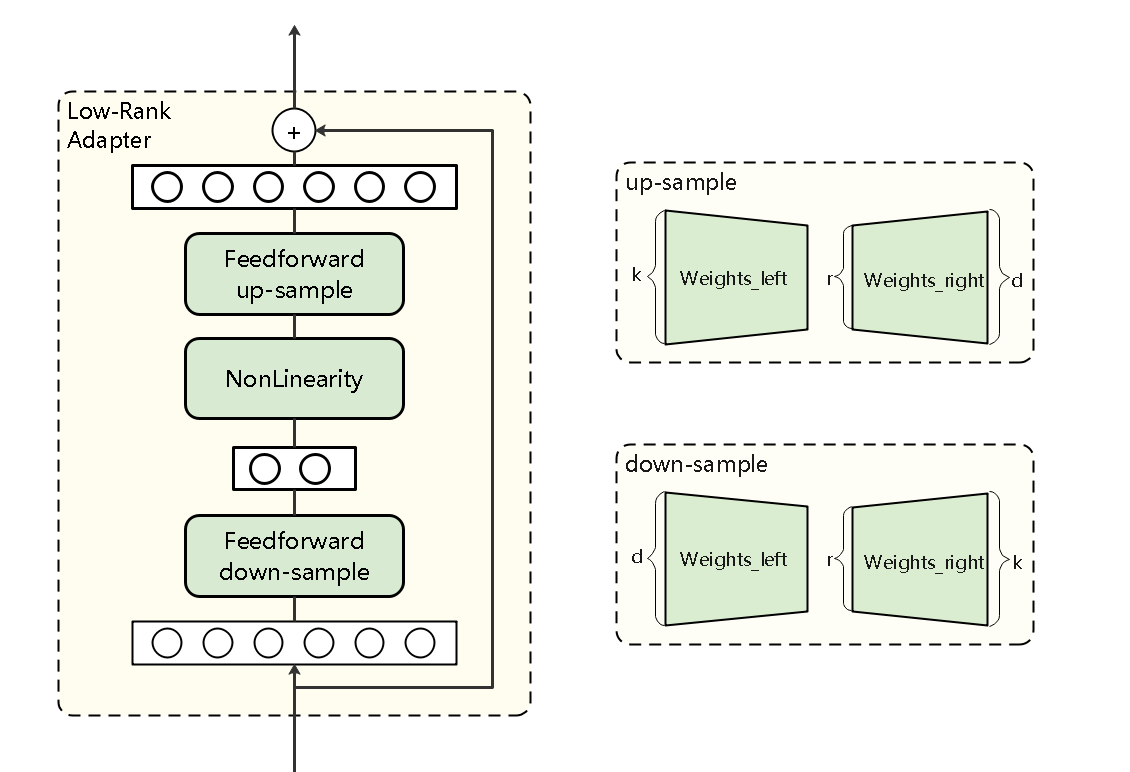

如论文中所述,其原理是将adapter层的每个矩阵分解成两个低秩矩阵的积,如原矩阵为kxr,则两个分解矩阵的大小分别是 (k)xr和rx(d)。为了减少参数量,通常把“r”设置为“1”。Low-Rank Adapter是作为adapter与compacter结构的中间演进版本,是一种特例化的compacter结构。

具体使用场景中,对每个Transformer Layer,在多头注意力模块后的Feed-forward Layer以及两个Feed-forward Layer的后面,添加Low-Rank Adapter结构。然后冻结预训练模型的参数, 仅更新Low-Rank Adapter结构参数。实验结果表明,添加了Low-Rank Adapter结构的Transformer模型,在仅训练少数参数情况下,微调后精度近似全参微调。

算法原理如图1所示,算法具体细节可参考相关论文Compacter: Efficient Low-Rank Hypercomplex Adapter Layers。

Low-Rank Adapter结构算法原理图:在原Dense层后接一个Low-Rank Adapter结构,包含降维全连接层、激活层、升维全连接层以及残差连接。

父主题: Low-Rank Adapter算法