快速介绍

TGI简介与TGI适配昇腾整体方案介绍

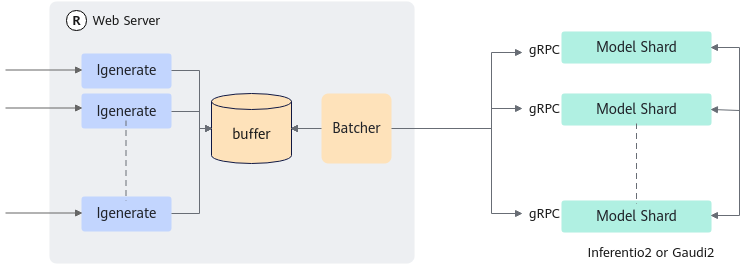

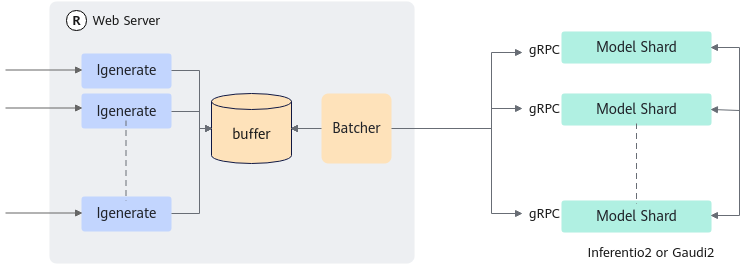

TGI(全称:Text Generation Inference)是HuggingFace支持的推理部署工具。TGI本身不支持NPU上的模型运行,通过提供昇腾环境下的TGI适配补丁,帮助客户在昇腾环境下运行TGI框架服务。适配后的系统:

- TGI服务的启动、与Client的交互协议、Batch调度和KV Cache分配功能仍然在TGI框架中完成。

- 模型推理与后处理能力:从开源TGI切换至MindIE LLM提供的统一接口。

图1 TGI开源架构

上图中,昇腾适配TGI的部分为Model Shard的部分。

支持的版本特性及模型

支持的TGI版本 |

浮点 |

量化 |

MoE |

单Lora |

多模态模型 |

|---|---|---|---|---|---|

v2.0.4 |

同MindIE LLM |

同MindIE LLM |

同MindIE LLM |

同MindIE LLM |

Qwen-VL |

V0.9.4 |

同MindIE LLM |

同MindIE LLM |

- |

同MindIE LLM |

- |