操作步骤

操作步骤

通过以下步骤进入一键式闭环工具进行配置:

- 选择并打开应用工程。

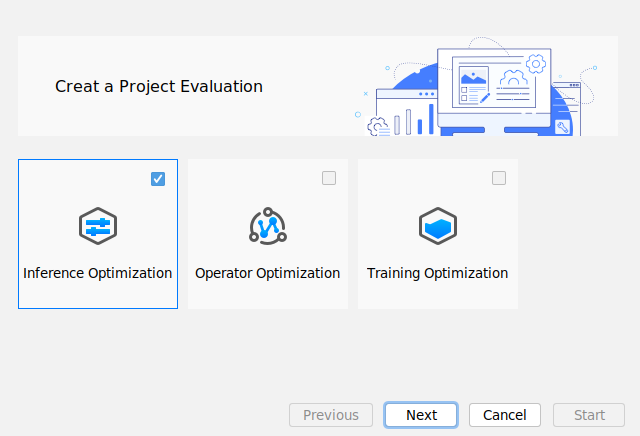

- 单击菜单栏,弹出一键式闭环工具界面 。如图1所示。

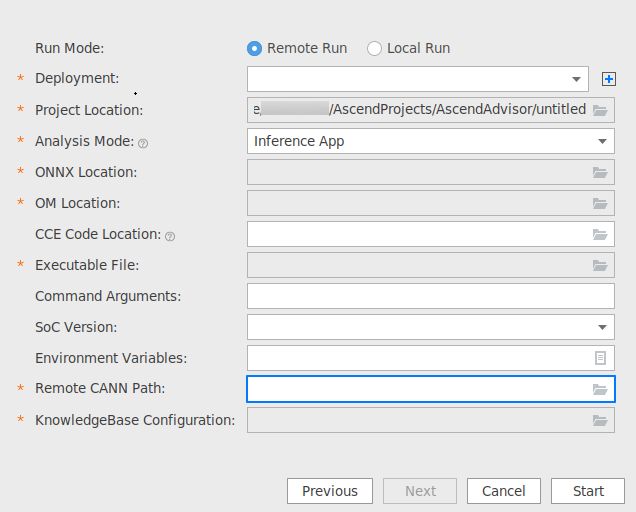

- 勾选图1界面中的“Inference Optimization”,打开配置界面,可选择Remote Run和Local Run模式且每种模式下可选择OM only和Inference App专家系统分析模式。图2以Remote Run模式下的Inference App模式为例。

表1 参数说明 配置项

说明

Run Mode

- Remote Run:远程运行。

- Local Run:本地运行。

Windows使用场景下仅支持Remote Run,该参数不展示。

Deployment

运行配置,选择Remote Run模式时可见,必选配置。通过Deployment功能,详细请参见Deployment,可以将指定项目中的文件、文件夹同步到远程指定机器的指定目录。

Project Location

分析完成后的.json文件保存目录,默认为${HOME}/AscendProjects/AscendAdvisor/untitled,必选配置,可自定义。

Analysis Model

执行分析模式,必选配置,取值为:

- OM only:只对所选的OM模型进行分析。该模式下的可执行文件为内置标准可执行文件,无需手动指定。

- Inference App:对当前用户的应用下执行OM模型的分析,需指定Executable File参数的可执行文件main或Python脚本文件。

OM only模式只对模型进行标准化分析,若需要对用户应用下的模型进行精准分析请指定Inference App模式。

ONNX Location

ONNX模型目录。须指定为.onnx后缀文件。

OM Location

OM模型目录。须指定为待分析的ONNX模型执行模型转换后的.om文件。

CCE Code Location

指定CCE文件保存目录,获取方式参见分析功能与输入数据的对应关系,可选配置。不指定本参数时,专家系统的分析结果精度可能有所偏差。当前仅基于Roofline模型的算子瓶颈识别与优化建议功能需要。

Executable File

执行专家系统目标工程的可执行文件目录,支持指定二进制脚本文件main和Python脚本文件,获取方式请参见Linux场景编译运行,仅在指定Inference App模式时展示,必选配置。须保证Remote Run模式下指定的可执行文件能够在远端环境下正常编译与执行。

Command Arguments

用户APP的执行参数,由用户自行配置,参数之间用空格分隔,默认为空。Analysis Model选择Inference App时可见。

SoC Version

设置待分析文件所属设备的芯片版本。当前支持芯片为:

- Ascend310:表示待分析文件所属设备的芯片版本为Ascend310。

- Ascend310P1:表示待分析文件所属设备的芯片版本为Ascend310P1。

- Ascend310P3:表示待分析文件所属设备的芯片版本为Ascend310P3。

请根据所在环境选择对应的芯片类型。

Environment Variables

环境变量配置。需要配置Python依赖环境变量:

- PYTHONPATH=${PATH}/msadvisor-master:$PYTHONPATH

- LD_LIBRARY_PATH=${HOME}/python3/lib:$LD_LIBRARY_PATH

其中${PATH}为ONNX模型调优知识库保存目录,${HOME}为Python安装的家目录。

Remote CANN Path

远端运行环境CANN软件包安装路径,选择Remote Run模式时可见,必选配置。例如配置为Ascend-cann-toolkit安装目录/ascend-toolkit/{version}。

KnowledgeBase Configuration

知识库配置文件echosystem.json。该文件保存在ONNX模型调优知识库保存目录${PATH}/msadvisor-master/ecosystem/onnx_refactor/ecosystem.json

- 配置完成后单击“Start”启动专家系统性能瓶颈分析。

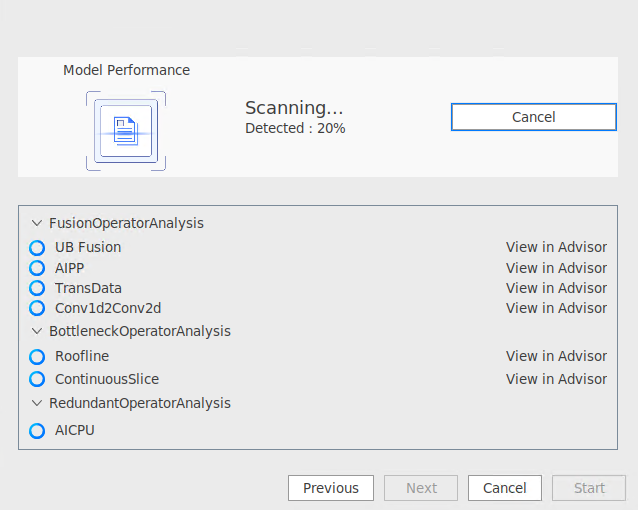

分析过程如图3所示。可随时单击“Cancel”取消任务或单击“Previous”重新配置参数。

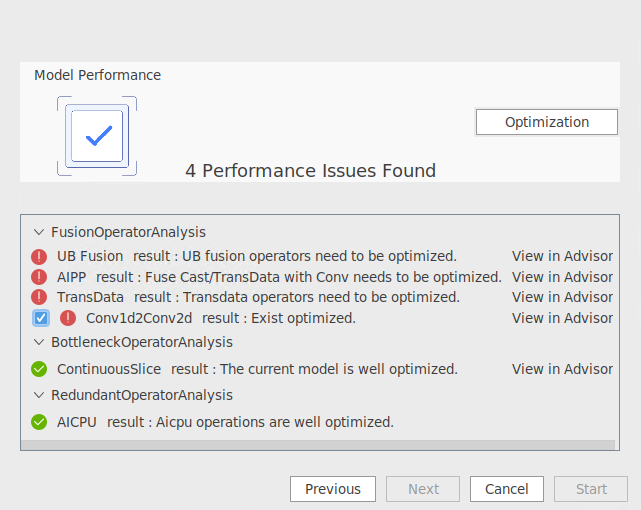

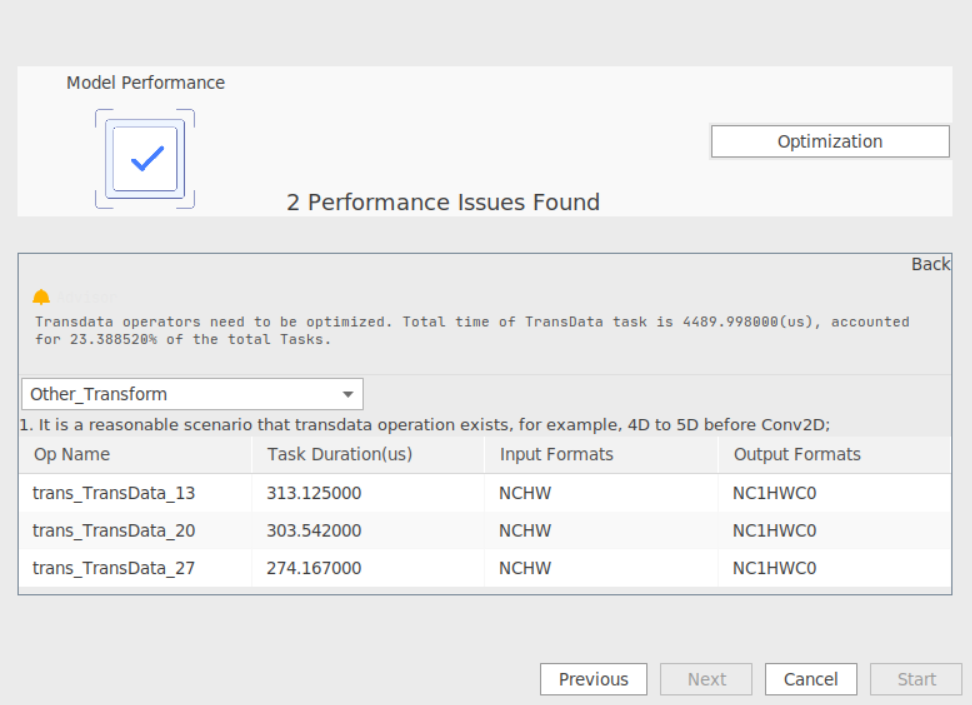

完成分析后的结果如图4所示。对于显示

的项,表示该模型无需调优;对于显示

的项,表示该模型无需调优;对于显示 的选项,可通过勾选该项并单击“Optimization”完成一键式性能调优;由于当前仅支持部分性能问题调优,对于无法勾选的项可以通过单击“View in Advisor”查看性能瓶颈和优化建议,如图5所示。

的选项,可通过勾选该项并单击“Optimization”完成一键式性能调优;由于当前仅支持部分性能问题调优,对于无法勾选的项可以通过单击“View in Advisor”查看性能瓶颈和优化建议,如图5所示。

AI CPU当前不支持单击“View in Advisor”查看性能瓶颈和优化建议。

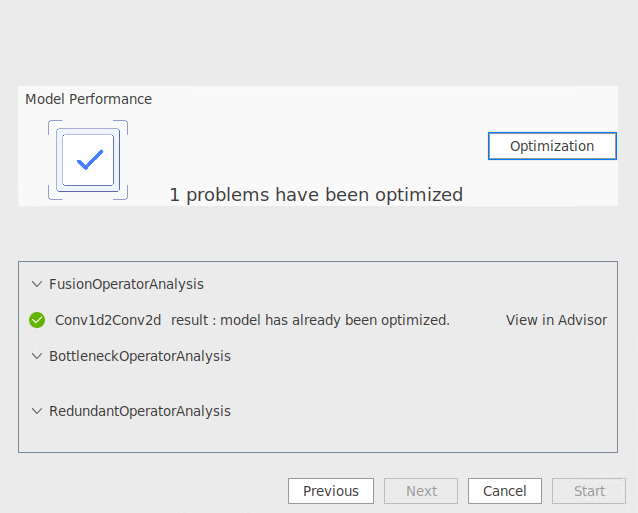

单击“Optimization”调优后结果如下。

图6 调优结果

性能调优一键式闭环能力在不断完善中。