模型加载

从模型构建中的说明构建出模型后,需进行模型加载,为模型执行做准备。

接口调用流程

开发应用时,如果涉及整网模型推理,则应用程序中必须包含模型加载的代码逻辑,关于模型加载的接口调用流程,请先参见pyACL接口调用流程了解整体流程,再查看本节中的流程说明。

本节描述的是整网模型加载的接口调用流程,对于算子模型加载与执行的详细说明请参见单算子调用。

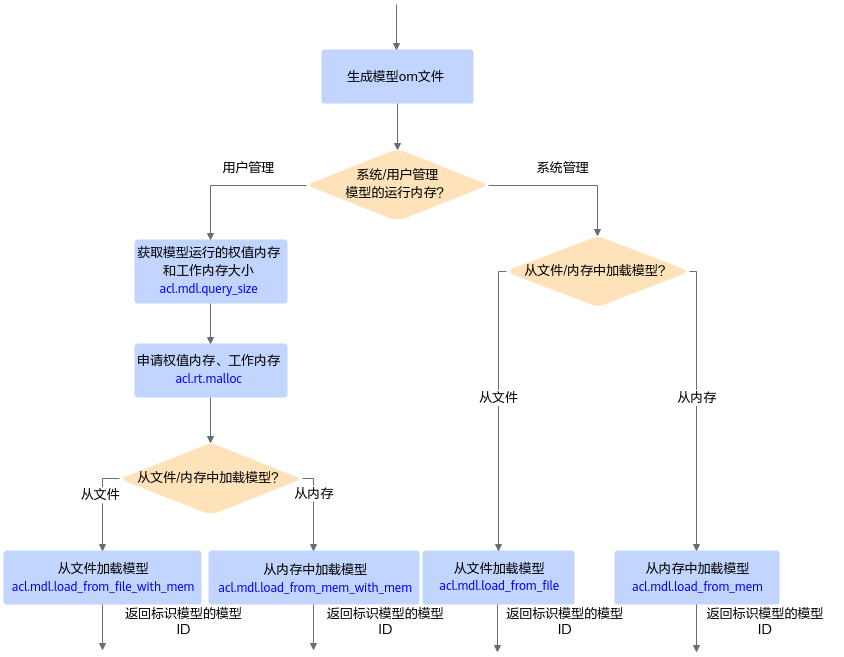

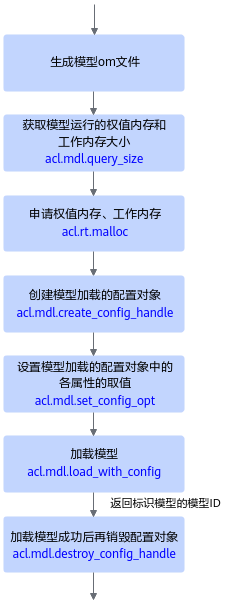

pyACL提供两套模型加载的接口,用户可根据具体使用场景选择对应的模型加载接口:

- 如图1所示,根据不同的加载方式(从文件加载、从内存加载等)选择不同的接口,操作相对简单,但需要记住各种方式的加载接口。

- 如图2所示,针对不同的加载方式(从文件加载、从内存加载等),只需设置接口中的配置参数,适用各种加载方式,但涉及多个接口配合使用,分别用于创建配置对象、设置对象中的属性值、加载模型。

关键接口的说明如下:

- 在模型加载前,需要先构建出适配昇腾AI处理器的离线模型(*.om文件),构建方式请参见模型构建。

- 由用户管理内存时,为确保内存不浪费,在申请工作内存、权值内存前,需要调用acl.mdl.query_size接口查询模型运行时所需工作内存、权值内存的大小。

如果模型输入数据的Shape不确定,则不能调用acl.mdl.query_size接口查询内存大小,在加载模型时,就无法由用户管理内存,因此需选择由系统管理内存的模型加载接口(例如,acl.mdl.load_from_file、acl.mdl.load_from_mem)。

- 支持以下方式加载模型,模型加载成功后,返回标识模型的模型ID:

示例代码

模型加载成功,会返回标识模型的ID,在模型执行时需要使用该ID。

调用接口后,需增加异常处理的分支,并记录报错日志、提示日志,此处不一一列举。以下是关键步骤的代码示例,不可以直接拷贝运行,仅供参考。

# 初始化变量。

model_path = "./model/resnet50.om"

# ......

# 加载离线模型文件(适配昇腾AI处理器的离线模型),由系统管理模型运行的内存(包括权值内存、工作内存)。

# 模型加载成功,返回标识模型的ID。

model_id, ret = acl.mdl.load_from_file(model_path)

# ......

父主题: 模型推理